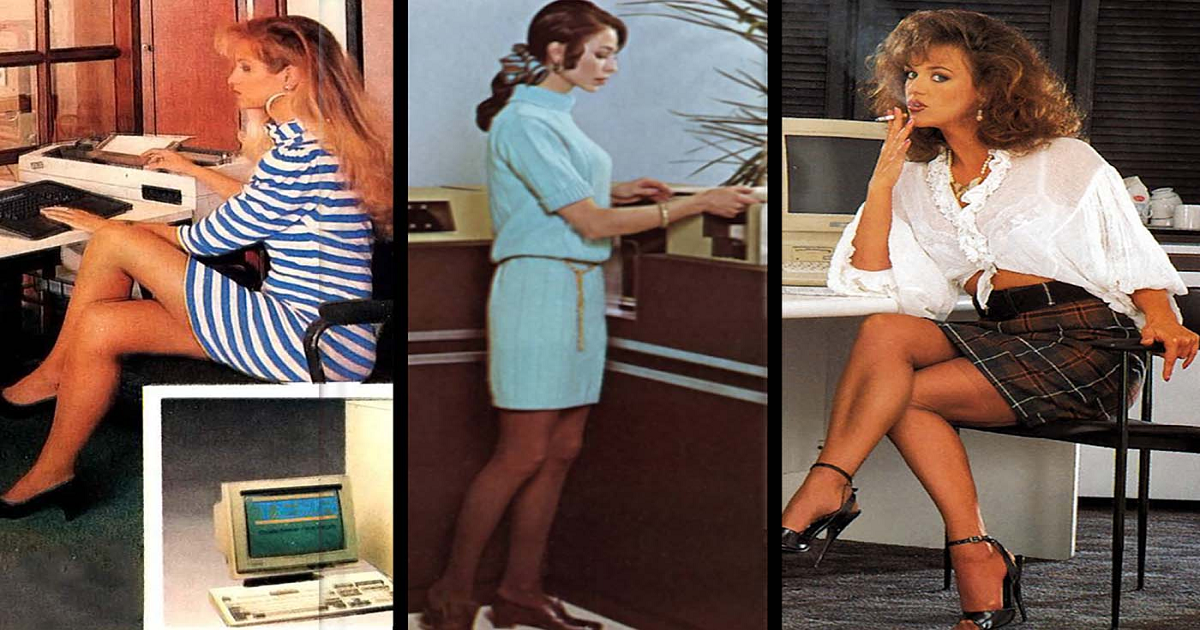

Quando gli inserzionisti usavano donne in minigonna per promuovere i sistemi informatici, anni '60 -'80

L'idea che il sesso vende tecnologia è stata sfruttata a fini grotteschi durante l'era dei primi giganteschi sistemi informatici.

Queste immagini d'epoca scansionate da vecchie riviste e giornali di quei decenni passati, ritraggono donne attraenti che indossano pochi vestiti quanto la decenza del giorno ha permesso di promuovere e pubblicizzare computer.

Le innovazioni tecnologiche come la diminuzione del costo dell'hardware e la crescente miniaturizzazione dei computer hanno creato nuovi mercati per i computer durante gli anni '70. I piccoli uffici potrebbero trarre vantaggio da computer a basso costo o ottenere l'accesso a mainframe attraverso servizi di time-sharing.

L'aumento dell'uso dei computer è stato accompagnato da importanti cambiamenti tecnici, organizzativi e sociali sul posto di lavoro, che hanno portato ad adattare ampiamente i processi aziendali esistenti all'elaborazione elettronica dei dati, determinando una rapida crescita dei requisiti per nuove qualifiche lavorative negli uffici e nei produzione.

Le aziende iniziarono a lavorare con i sistemi informatici all'inizio degli anni '60. Questi sistemi sono stati installati nei centri di calcolo.

I costi operativi di un tale centro di calcolo erano così alti che i sistemi dovevano funzionare giorno e notte per essere redditizi.

Sono state solo le grandi aziende a generare volumi di dati così elevati. Di conseguenza, sono state le grandi banche e le compagnie assicurative a istituire per prime i centri di calcolo.

Lì lavorava un piccolo numero di specialisti di computer molto rispettati: programmatori che scrivevano il software e operatori che gestivano i sistemi.

Nel 1975, il microcomputer è stato introdotto nel settore delle piccole imprese. Grazie alla tecnologia dei microcomputer, le piccole imprese sono state in grado di competere con le grandi entità aziendali avendo la capacità di analizzare i dati aziendali.

La prima applicazione dei computer si basava sui loro vantaggi rispetto agli umani nel seguire ripetutamente semplici istruzioni, ad esempio la tabulazione dei risultati del censimento.

Nel corso del tempo, l'hardware del computer è diventato notevolmente più capace e i progressi nel software, come elaboratori di testi, fogli di calcolo ed e-mail, hanno reso più facile per i lavoratori l'accesso a queste funzionalità.

Gli anni '80, però, videro la vittoria di un'idea che solo pochi visionari avevano osato intrattenere: portarono il computer su ogni scrivania – il personal computer , o PC.

Quando finalmente IBM lanciò il suo primo PC nel 1981, la gente si lamentò del suo sistema operativo MS-DOS, che era considerato la seconda scelta.

Tuttavia, i clienti ritenevano che la reputazione di Big Blue fosse più importante dello stato della tecnologia del prodotto e fecero del PC IBM lo standard per le applicazioni per ufficio.

Il sistema operativo dell'Apple Macintosh, invece, fu rivoluzionario nel 1984. Portò icone, finestre e mouse sui desktop ma il Mac non si vendette bene finché non apparve un'applicazione - il desktop publishing - per la quale il Mac era più adatto di qualsiasi altro computer.

Questo boom è stato, ovviamente, favorito dai progressi nella tecnologia dei semiconduttori. La legge di Moore illustra il dinamismo di questo settore. Ha predetto che la potenza e la complessità dei chip per computer sarebbero raddoppiate e il loro prezzo si sarebbe dimezzato ogni 18 mesi.

Ciò ha reso possibile eseguire applicazioni che richiedevano una potenza di calcolo sempre maggiore. Ben presto, i PC elaborarono immagini fisse e in movimento oltre al suono.

Hanno suscitato l'interesse degli artisti ma, soprattutto, hanno dato vita a un enorme mercato di prodotti per l'intrattenimento. Nell'industria dei computer, originariamente sviluppata per clienti militari, sono i produttori di famosi giochi per computer che ora dettano il ritmo.

I PC erano economici, ma c'era ancora un mercato per computer desktop più potenti realizzati per soddisfare i requisiti imposti da ingegneri e architetti sulla progettazione assistita da computer piuttosto che per gli utenti di ufficio o domestici.

Come nel caso dei PC, queste prime workstation, come venivano chiamati questi computer per distinguerli dai PC, provenivano da un nuovo arrivato sulla scena: Sun Microsystems con sede nella Silicon Valley.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.