Floppy disk e MS-DOS, due storie opposte di tecnologia vintage

Negli anni '80 e '90, il mondo della tecnologia ha vissuto un'epoca di straordinarie innovazioni e cambiamenti. Tra i protagonisti di questo periodo vi sono stati due elementi fondamentali: il floppy disk e il sistema operativo MS-DOS. Sebbene abbiano avuto percorsi molto diversi, entrambi hanno lasciato un'impronta indelebile nel panorama tecnologico.

Il Floppy Disk: La Rivoluzione del Supporto di Memorizzazione

Il floppy disk, inventato da IBM nel 1967, ha rivoluzionato il modo in cui i dati venivano memorizzati e trasferiti. Originariamente da 8 pollici, fu poi ridotto a 5,25 pollici e infine a 3,5 pollici, il formato più noto. Questi dischetti erano capaci di contenere da pochi kilobyte a 1,44 megabyte di dati, un'enormità per l'epoca.

La portabilità del floppy disk rappresentava una svolta. Consentiva agli utenti di trasferire facilmente file da un computer all'altro, fare copie di backup e distribuire software. Per molti, il floppy disk fu il primo supporto di memorizzazione rimovibile. Era sinonimo di libertà e convenienza in un'era in cui internet era ancora agli albori.

Tuttavia, con l'avvento di supporti più capienti e affidabili come i CD-ROM, i DVD e le chiavette USB, il floppy disk iniziò il suo declino. La sua capacità limitata e la vulnerabilità ai danni fisici lo resero obsoleto. Negli anni 2000, i computer iniziarono a essere venduti senza unità floppy, segnando la fine di un'era.

MS-DOS: Il Sistema Operativo che Ha Definito una Generazione

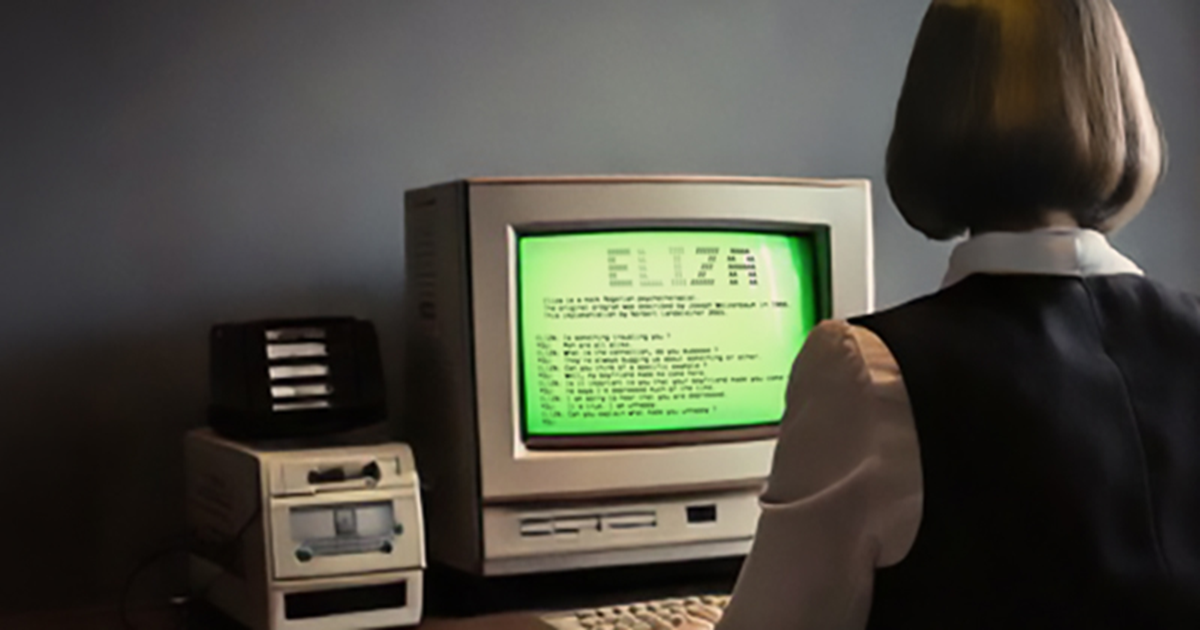

MS-DOS (Microsoft Disk Operating System) nacque nel 1981 quando Microsoft acquistò un sistema operativo chiamato 86-DOS, lo adattò e lo rivendette a IBM per il suo primo PC. MS-DOS divenne rapidamente il sistema operativo standard per i personal computer IBM e i loro cloni.

A differenza del floppy disk, che era un supporto fisico, MS-DOS era un software, il cervello che gestiva le operazioni del computer. Era un'interfaccia a riga di comando, senza grafica, dove gli utenti dovevano digitare comandi testuali per eseguire programmi, gestire file e configurare hardware. Per molti, imparare a usare MS-DOS fu il primo passo verso la comprensione dei computer.

MS-DOS dominò il mercato dei sistemi operativi per oltre un decennio, fino all'arrivo delle interfacce grafiche come Windows. Nonostante la sua semplicità e la mancanza di interfaccia grafica, MS-DOS era potente e flessibile, permettendo agli utenti di avere un controllo diretto sul sistema.

Con il passare del tempo, i sistemi operativi divennero sempre più sofisticati e orientati all'utente finale, riducendo la necessità di conoscenze tecniche approfondite. Microsoft introdusse Windows, che progressivamente sostituì MS-DOS come sistema operativo principale, portando con sé un'interfaccia grafica più user-friendly.

Due Percorsi di Innovazione

Mentre il floppy disk e MS-DOS rappresentano due aspetti diversi della tecnologia vintage, entrambi hanno avuto un ruolo cruciale nello sviluppo dei computer personali. Il floppy disk, con la sua portabilità e praticità, ha cambiato il modo di gestire e trasferire i dati. MS-DOS, con la sua semplicità e potenza, ha introdotto milioni di persone all'uso dei computer.

Oggi, entrambi sono considerati obsoleti, ma il loro impatto sulla tecnologia e sulla cultura informatica è innegabile. Hanno gettato le basi per le innovazioni future e rimangono icone di un'era passata, ricordate con nostalgia da chi ha vissuto quei primi giorni dell'informatica.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.