La storia del malware

Un'analisi delle minacce dal primo worm diffuso su Arpanet al primo virus informatico in assoluto (per Apple II), per poi arrivare ai giorni nostri.

“Virus informatico" è uno dei pochi termini tecnici che tutti riconoscono immediatamente

Indipendentemente dal proprio background o dall'età, chiunque lo senta gli darà un’immediata connotazione negativa, dal momento che solitamente viene associato a qualcosa di distruttivo per la tecnologia su cui tutti facciamo affidamento quotidianamente, che si tratti di un computer portatile, uno smartphone, un'applicazione o un sistema di gaming.

Un percorso nella storia del malware informatico, dall'era pre-internet al giorno d’oggi, un mondo popolato di botnet, ransomware, virus, worm e molto altro.

1971: il primo Proof of Concept

Prima ancora che esistesse internet, almeno nella forma che conosciamo oggi, il suo predecessore era l'Advanced Research Projects Agency Network, o ARPANET, in breve. ARPANET iniziò a lavorare nel 1967 con l’obiettivo di collegare tra loro i computer remoti. Il primo collegamento avvenne nel 1969, e un anno dopo fu sviluppato il Network Control Program (NCP) (l’antesignano del moderno stack TCP/IP.) NCP fu il primo livello di trasporto di rete utilizzato per consentire il flusso di dati da computer a computer.

Nel 1971 fu sviluppato il primo microprocessore, l'Intel 4004, ovvero la prima CPU in grado di adempiere a più scopi prodotta commercialmente. Le sue dimensioni (due pollici invece di 12), il suo prezzo (60 dollari) e le sue prestazioni (paragonabili a quelle di processori molto più grandi e costosi) inaugurarono una nuova era dell'informatica.

Ironicamente, i 1971 fu anche l’anno in cui si presentò sulla scena il primo virus “Proof of Concept”, soprannominato "The Creeper". Anche se indicato da più parti come il primo virus informatico che il mondo avesse visto, esso in realtà mostrava il comportamento di un worm. Basato su un concetto articolato per la prima volta dal matematico tedesco John von Neumann negli anni '40, esso fu creato alla BBN (una società americana di ricerca e sviluppo poi acquisita da Raytheon) dall'ingegnere Bob Thomas. Il virus si diffuse attraverso i computer ARPANET e pubblicò il seguente messaggio: "I'm the creeper, catch me if you can!"

Come i suoi moderni successori di tipologia “worm”, The Creeper si diffuse attraverso un protocollo di rete. L'intento non era malevolo, in questo caso si voleva infatti capire se il messaggio avrebbe potuto propagarsi ad altri computer tramite ARPANET. Ed è esattamente quello che accadde.

1982: il primo virus per Mac

Contrariamente al comune pensiero che i Mac non siano suscettibili ai virus, il primo virus informatico, soprannominato "Elk Cloner", fu progettato per colpire proprio i computer Apple II. Fu scritto da un quindicenne, che lavorava a questo tipo di programmi per fare scherzi ai suoi amici. Questo virus del boot sector si propagava ogni volta che un disco infetto veniva eseguito; rimaneva in memoria e cercava ogni volta un floppy disk da infettare.

1986: il primo virus per PC

Nel 1986, l'informatica era ancora rudimentale, le operazioni erano lente e i dispositivi non erano collegati a Internet. Le primissime iterazioni di internet erano limitate ad ambiti precisi, come i governi e le università. Ci sarebbero voluti almeno tre anni prima che gli Internet Service Provider (ISP) iniziassero a fornire un accesso pubblico a internet, e questo avvenne nel 1989.

Certo, esistevano già i Bulletin Board Systems (BBS), ma il loro utilizzo richiedeva una telefonata a un Point of Presence diretto (POP) ospitato dall'operatore del BBS. Le connessioni erano di solito limitate al pubblico locale del singolo BBS, perché le telefonate provenienti dall’esterno di un determinato prefisso erano fatturate al minuto, il che le rendeva piuttosto costose.

Il 1986, nello specifico, ha visto la nascita del primo virus per PC, soprannominato "Brain", che ha cambiato il volto della sicurezza informatica come la conosciamo oggi. Questo virus ha avuto origine in Pakistan, ma si è rapidamente diffuso in tutto il mondo in Europa e Nord America, replicandosi da macchina a macchina a causa di una contromisura anti-pirateria.

Il virus Brain fu sviluppato da Amjad e Basit Farooq Alvi, due fratelli del Pakistan che crearono un virus del boot sector con un avvertimento a chi utilizzava una copia pirata del loro software medico. Poiché internet non esisteva ancora, questo virus si diffuse tramite riproduzione su floppy disk. All'insaputa dell'utente, il master boot record (MBR) della macchina della vittima veniva infettato mentre realizzava una copia illegale del virus e si diffondeva quando il disco veniva inserito nella macchina successiva. Poiché non c'era modo di sapere che un virus MBR infetto era in arrivo, si diffuse fino a diventare un fenomeno globale.

Fortunatamente, Brain non era un virus distruttivo. Nascondeva un settore particolare in modo che la macchina non fosse in grado di avviarsi e mostrava una notifica che includeva informazioni di contatto dei fratelli Farooq Alvi per porre rimedio al problema. Essi affermano che il loro scopo era quello di fare in modo che le persone colpite li contattassero per discutere sul modo per ottenere il loro software legalmente.

1988: il worm Morris

La differenza tra un virus e un worm è che un worm non ha bisogno dell'interazione umana per propagarsi. Il primo worm al mondo è stato creato più di 30 anni fa: il suo nome, Morris, derivava da quello del suo autore Robert Morris e si trattava di un worm senza scopi malevoli. Morris era stato infatti creato come un Proof of Concept per capire se fosse possibile una replicazione hands-off.

Questo worm portò con sé diverse novità. In primis, era in grado di sfruttare le vulnerabilità esistenti in vari programmi e servizi e riusciva a controllare se fosse presente un'infezione esistente, tutti comportamenti tipici del malware moderno. E poiché il suo creatore si era posto il problema che gli amministratori di sistema avrebbero messo in quarantena il worm e ignorato l'infezione, lo programmò per essere persistente. Tuttavia, non c'era modo di fermare il processo di auto-replicazione del worm, che causava carichi elevati sui dispositivi, rendendoli inutilizzabili, provocando un denial-of-service (DoS) nei network mentre si diffondeva da macchina a macchina.

Morris fu il primo condannato secondo il Computer Fraud and Abuse Act. Nonostante ciò, divenne in seguito un imprenditore di successo e ottenne la cattedra al Massachusetts Institute of Technology (MIT).

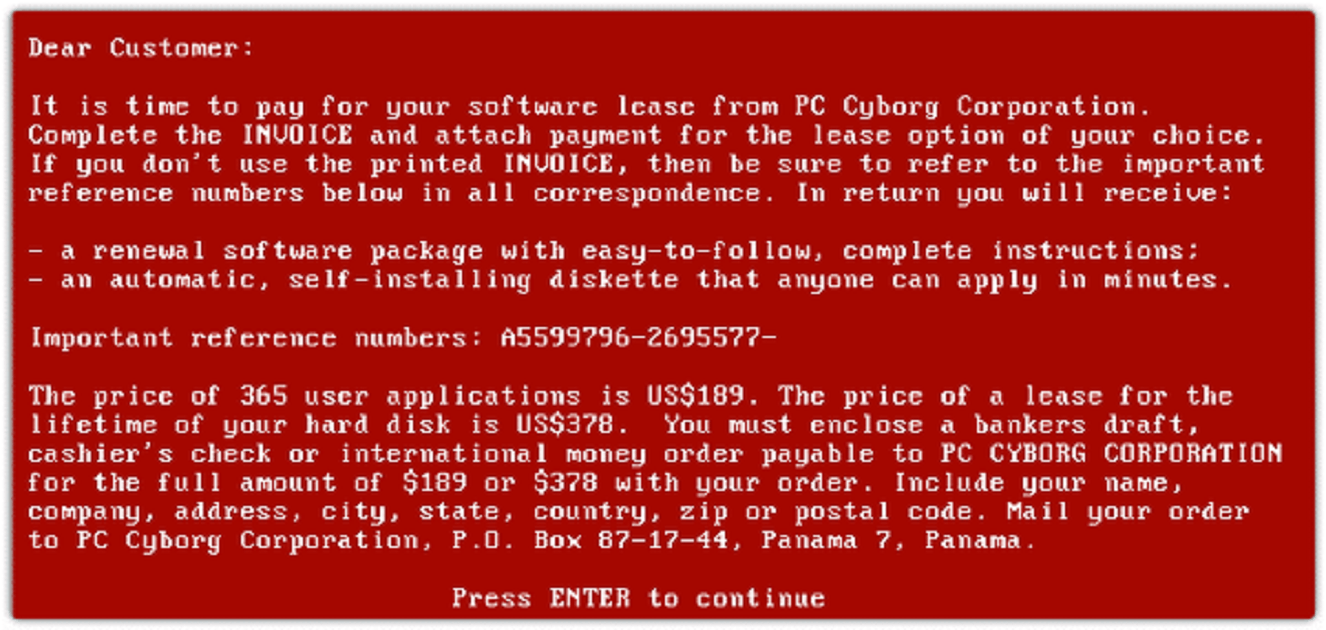

1989: il primo ransomware al mondo

Il 1989 vide il debutto del Trojan AIDS, il primo ransomware mai osservato. Per coincidenza nello stesso anno venne reso disponibile l’accesso a internet al di fuori degli Stati Uniti attraverso un ISP chiamato TheWorld. Tuttavia, il ransomware non ha approfittato della connettività Internet per infettare e colpire le sue vittime fino al 2005.

Nel 1989, le notizie relative al virus umano dell'AIDS erano di grande attualità e avevano una risonanza a livello mondiale. Il trojan AIDS fu inviato per posta (sì, posta fisica, non via e-mail) ai ricercatori di tutto il mondo che si occupavano di AIDS tramite 20.000 floppy disk infetti. Una volta che il disco veniva eseguito, mostrava di contenere proprio un questionario sull'AIDS. Ma al novantesimo reboot, cambiava i nomi dei file in stringhe criptate e li nascondeva all'utente. Lo schermo mostrava poi una richiesta di 189 dollari per un leasing annuale o 385 dollari per una licenza a vita, da inviare a una casella postale a Panama. Erano accettati solo assegni bancari o circolari oppure vaglia.

Il Trojan AIDS venne attribuito al defunto Dr. Joseph Popp, che affermò di aver creato il ransomware per donare i fondi raccolti alla ricerca sull'AIDS. Tuttavia, altri report affermano che fosse in attrito con l'Organizzazione Mondiale della Sanità, dopo essere stato rifiutato per una posizione lavorativa. Una nota interessante riguarda il fatto che il dottor Popp non inviò nessuno dei suoi floppy disk ai ricercatori basati negli Stati Uniti.

1992: Michelangelo

Il 1992 fu la volta di Michelangelo, un virus del boot sector che prendeva di mira le partizioni DOS. Era scritto in Assembly e, come i suoi predecessori, venne diffuso mediante l’utilizzo di floppy disk, modalità scelta in quanto esso prendeva di mira il master boot record e i floppy store collegati, permettendo così la diffusione durante il processo di copia e caricamento.

Il nome Michelangelo nasce dal fatto che questo virus era stato programmato come una bomba a orologeria, con l’indicazione di attivarsi il 6 marzo, ricorrenza del compleanno di Michelangelo Buonarroti. Ciò che lo rese celebre fu che -dopo la sua scoperta- ci fu una grande copertura mediatica, mediante la quale gli utenti vennero avvisati di tenere i computer spenti in quel giorno o di cambiare la data sulle loro macchine al giorno precedente per evitare di essere colpiti. É stata la prima volta che un virus ha ricevuto così tanta attenzione dai media tradizionali, sia sulla stampa che in televisione, contribuendo a incentivare le vendite di software antivirus in tutto il mondo.

1994-95 lo scenario “warez” e i primi attacchi di phishing

Se l’utilizzo di internet in America è stato spinto dal lancio di servizi come America Online (AOL), CompuServe e Prodigy, lo stesso è accaduto per truffe e phishing. Per molti che sono cresciuti utilizzando le chatroom di AOL, lo scenario progz (slang per programmi) e warez (slang per software) della metà degli anni '90 fu rivoluzionario. Poiché l'accesso a internet via dial-up era piuttosto costoso, essendo addebitato al minuto, molti cybercriminali avevano tutto l’interesse a rubare le credenziali degli account.

Nuovi programmi cominciarono ad essere scambiati su chatroom warez illecite che contenevano punterz (per mandare offline gli utenti), progz di phishing (per rubare gli account degli utenti), e strumenti usati per generare carte di credito random. Uno dei programmi più famosi era AOHell, un gioco di parole basato proprio sul nome di AOL, che conteneva un creatore di account casuali, che a sua volta utilizzava account di carte di credito creati a caso per aprire un account gratis per un mese.

Esso conteneva inoltre una delle prime evidenze di phishing: falsi bot automatici di messaggi istantanei AOL inviavano comunicazioni ai propri target chiedendo loro di verificare le credenziali del loro account, sostenendo che ci fosse un problema di fatturazione o qualche problema simile. Per continuare a interagire con il bot, la vittima avrebbe dovuto "verificare la propria identità" inserendo il proprio nome utente e password. Queste informazioni sarebbero state poi raccolte dagli utenti del programma AOHell per utilizzarle oppure rivenderle per l'accesso gratuito all'account o per l’invio di spam.

Nelle stanze di warez su AOL era inoltre possibile imbattersi in programmi promettevano di compiere azioni specifiche, mentre in realtà si trattava di collettori di credenziali che prendevano di mira i "n00b" disinformati, o gli utenti principianti/neofiti.

Benvenuti nell’ “Y2K”

L'alba del nuovo millennio ha visto un numero sempre maggiore di connessioni a livello globale. Allo stesso tempo, a causa dell'aumento del numero di vittime potenziali, c'è stato un deciso aumento del volume degli attacchi.

Il 1999 viene ricordato per la crescita di nuove aziende high-tech (la cosiddetta “bolla dotcom”), ma è stato anche l’anno in cui si è diffuso il bug "Y2K". Anche se non si trattava di un virus, Y2K causò un panico diffuso perché si temeva che i computer con vecchi sistemi operativi avrebbero smesso di funzionare dopo il 31 dicembre 1999, a causa di un difetto di progettazione nel BIOS, che controlla la scheda madre del computer. L’idea diffusa era quella che, quando fosse stato riavviato il 1° gennaio 2000, il sistema operativo sarebbe stato portato a credere che si trattasse invece del 1° gennaio 1900, interrompendo tutta una serie di attività cruciali: dalle pompe di benzina agli ascensori, dai trading floor alle centrali elettriche. Fortunatamente, questo difetto di progettazione si dimostrò essere meno problematico di quanto si pensasse, e la maggior parte delle organizzazioni e degli individui ne uscì indenne. Ma le notizie relative a Y2K dominarono i media di tutto il mondo per mesi.

1999/2000: appare la prima botnet

Nel 2000, l'accesso a banda larga stava iniziando a guadagnare terreno, diffondendosi oltre quelle organizzazioni che potevano permettersi l'accesso a una linea T1 tramite connessioni DSL (Digital Subscriber Line). Gli utenti domestici e le aziende avevano la possibilità di essere online 24x7 e, negli anni successivi, i criminali informatici hanno sfruttato tutto questo per inaugurare l’era delle botnet e dei worm.

Quando comparvero le botnet, l'IA era ancora fantascienza, questo tuttavia non significa che esse non fossero un problema. All'epoca, le botnet erano relativamente semplici: sostanzialmente, infettavano e si diffondevano tra le macchine. La maggior parte del malware botnet si connetteva a un server predeterminato di comando e controllo (C2) su una Internet Relay Chat (IRC - pensate alle vecchie chatroom AOL) per ricevere istruzioni.

EarthLink Spam, che fece il suo debutto nel 2000, fu la prima botnet identificata ed aveva un compito molto semplice: inviare massicce quantità di spam. Il suo volume era molto alto, essa rappresentava infatti il 25% di tutto lo spam e-mail distribuito all'epoca, per un totale di circa 1,25 miliardi di messaggi. Tuttavia, la prima botnet vera e propria venne creata qualche anno prima, nel 1999. Si trattava di GTbot che, a livello di malware, era molto rudimentale. In sostanza, si diffondeva ad altre macchine e riceveva comandi via IRC. Questi comandi venivano emessi dai controller di GTbot, che usavano la rete di dispositivi colpiti (denominati “zombie”) per lanciare attacchi DDoS (distributed denial-of-service).

ARRIVANO I WORM!

2000: I LOVE YOU Blaster Sasser

Il worm I LOVE YOU, creato da Onel De Guzman, uno studente universitario nelle Filippine, inaugurò il millennio aggiudicandosi una grande copertura mediatica, data dal fatto che riuscì a diffondersi in tutto il mondo a velocità record.

I LOVE YOU si propagava utilizzando più dinamiche. In primo luogo, veniva inviato agli utenti via e-mail tramite un allegato nominato "LOVE-LETTER-FOR-YOU.vbs.txt". Quando esso veniva aperto, il worm identificava la rubrica di Microsoft Outlook per poi inviare e-mail impersonando la vittima e replicandosi come allegato. Poiché generalmente gli utenti tendevano a fidarsi delle e-mail provenienti da persone conosciute, questa nuova modalità d’azione causò l'infezione di milioni di computer in pochi giorni. Questo metodo di fare scraping, impadronendosi della rubrica di un target per poi impersonarlo nelle e-mail, viene ancora usato come parte delle attività di spionaggio dei cybercriminali (si pensi, ad esempio, a EMOTET).

2003: Blaster (MSBlast, lovesan)

Nel 2003, ormai molti individui e organizzazioni erano collegati a Internet con una connessione a banda larga, il che ha dato origine ad una serie da record di attacchi da parte di worm e wormlike.

L'11 agosto 2003, venne lanciato Blaster (noto anche come MSBlast e lovesan). Gli utenti domestici e i dipendenti delle grandi aziende rimasero letteralmente spiazzati dalla comparsa sugli schermi dei loro computer del temuto "Blue Screen of Death" (BSOD) e dal successivo riavvio. Quello che non sapevano è che il responsabile di tutto ciò era il worm Blaster.

Blaster agiva prendendo di mira una vulnerabilità RPC (Remote Procedure Call) nei sistemi operativi Microsoft Windows XP e 2003 con lo scopo di propagarsi in tutto il mondo. L'obiettivo del worm era quello di eseguire un attacco SYN flood contro windowsupdate.com per impedire alle macchine di accedere agli aggiornamenti. Fortunatamente per Microsoft, l'autore fece l'errore di fare in modo che Blaster prendesse di mira il dominio sbagliato. Windowsupdate.com non era infatti essenziale, poiché le macchine utilizzavano invece windowsupdate.microsoft.com per ricevere gli aggiornamenti.

A causa di un bug, il worm non fu del tutto inefficace, provocando un denial-of-service (BSOD) dovuto a un buffer overflow. I continui riavvii non erano d’aiuto per ostacolare le attività del worm, in quanto esso semplicemente le ricominciava, spegnendo le macchine più e più volte. A causa dell'ampia adozione della connettività Internet, questo diventò il primo attacco globale di denial-of-service.

Di particolare rilevanza è il fatto che Blaster non colpì le organizzazioni che avevano applicato le patch (MS03-026) prima dell'11 agosto. Questo esempio sottolinea l'importanza di applicare le patch ai sistemi aziendali il più velocemente possibile. Sfortunatamente, ancora oggi, molte organizzazioni non prendono sul serio questo consiglio.

L’ALBA DEL CYBERCRIME

2005: la prima combinazione di worm, backdoor e botnet

Sino al 2005, il malware fu perlopiù appannaggio degli appassionati che lo creavano per provare a combinare qualche guaio o per pura curiosità. Le varianti Mytob/Zotob cambiarono questo scenario.

Mytob aveva la particolarità di combinare le funzionalità di worm, backdoor e botnet. Si trattava di una variante di MyDoom ed era stato creato dalla stessa persona che aveva creato il worm Zotob. Mytob infettava le macchine delle sue vittime in due modi: si diffondeva via e-mail attraverso allegati malevoli, oppure sfruttava le vulnerabilità nel protocollo LSASS (MS04-011) o RCP-DCOM (MS04-012) e utilizzava l'esecuzione di codice da remoto. In aggiunta, era in grado di usare la rubrica delle vittime per propagarsi, utilizzando le scansioni di rete per cercare altre macchine e vedere se potevano essere compromesse.

In aggiunta, Mytob fu uno dei primi virus a bloccare o ostacolare l’azione del software anti-virus, impedendo che le macchine delle vittime potessero connettersi ai siti in grado di fornire update. Questo avveniva, di fatto, reindirizzando tutti gli URI dei fornitori conosciuti a 127.0.0.1, un IP localhost. In questo modo tutte le query ai siti web rivolti al pubblico si risolvevano verso la macchina stessa, essenzialmente senza andare da nessuna parte. Mytob era costantemente presente nelle classifiche Top 10 delle minacce informatiche ed aveva così tante varianti con così tante funzionalità che le aziende che fornivano software anti-virus spesso dovevano aggiungere l'intero alfabeto al nome del malware.

La variante Zotob incorporò in ciò che restava di Mytobuna vulnerabilità di buffer overflow in Microsoft Plug and Play per Windows 2000, MS05-039. Zotob utilizzava questa variante per scansionare le macchine vulnerabili a MS05-039 e potersi poi propagare ulteriormente. Le varianti Mytob/Zotob hanno avuto effetti importanti, mettendo fuori uso l’operatività di oltre cento organizzazioni, tra cui il NY Times.

SPYWARE E RISULTATI DI RICERCA DIROTTATI

2005: CoolWebSearch e BayRob

CoolWebSearch, comunemente noto come "CWS”, è stata la prima operazione di cybercrimine a dirottare i risultati di ricerca da Google, sovrapponendoli con quelli degli stessi cybercriminali. Si trattava, in sostanza, di un’azione il cui scopo era quello di rubare click da Google. La distribuzione di CWS è avvenuta per la maggior parte utilizzando download drive-by o programmi adware: era così pervasiva e difficile da rimuovere, che alcuni volontari svilupparono programmi e crearono forum web per aiutare a rimuovere le infezioni CWS gratuitamente. Uno dei programmi utilizzati dalle vittime di CoolWebSearch per rimediare al danno subito dalle loro macchine era CWS Shredder.

Un attacco simile comparve diversi anni dopo, nel 2007. In questo caso ad essere usata era una variante di hijacking dei risultati di ricerca da eBay. Questa minaccia venne scoperta quando una donna in Ohio acquistò un'auto per diverse migliaia di dollari, ma il veicolo non le fu mai consegnato. Le autorità determinarono successivamente che l’automobile non era mai stata messa in vendita e che il device dell’utente era stato infettato da un malware che iniettava false inserzioni sul suo dispositivo tramite il malware BayRob.

ALLA SCOPERTA DELLE ARMI INFORMATICHE DEGLI STATI-NAZIONE

2010: Stuxnet

La decade del 2010 venne inaugurata dalla prima scoperta del malware di uno stato-nazione, utilizzato per colpire i dispositivi dei servizi di controllo industriale (ICS), in particolare i dispositivi di controllo e acquisizione dati (SCADA). Stuxnet si è caratterizzato come il primo malware specifico di uno stato-nazione capace di prendere di mira le infrastrutture critiche - in questo caso le centrifughe industriali (in particolare quelle nucleari), causandone l'overspin e provocando una fusione. Stuxnet prese di mira specificamente le organizzazioni in Iran, ma presto si diffuse ad altri sistemi SCADA in tutto il mondo. L'analisi del malware Stuxnet ha evidenziato che esso potrebbe essere adattato a qualsiasi organizzazione che gestisce dispositivi ICS simili. Nel 2012, un articolo del NY Times ha confermato che dietro allo sviluppo di Stuxnet c’erano Stati Uniti e Israele.

2011: Regin

Regin è un RAT (Remote Access Trojan) altamente modulare. Questa sua caratteristica gli ha consentito di essere particolarmente flessibile, adattandosi a un ambiente specifico. Regin ha avuto successo anche perché il suo funzionamento lo faceva apparire sostanzialmente innocuo. I file che venivano esfiltrati erano spesso conservati in un contenitore criptato; tuttavia – invece di essere memorizzati in più file – il suo contenuto veniva conservato in un’unica soluzione, evitando così di destare i sospetti degli amministratori di sistema o dei software AV. Secondo Der Spiegel, Regin era stato creato dalla NSA degli Stati Uniti e progettato per spiare l'UE e i suoi cittadini. Questa informazione è stata divulgata attraverso la famigerata fuga di informazioni classificate fornita da Edward Snowden.

2012: Flame

Quando venne scoperto, Flame era considerato il malware più avanzato mai identificato. Aveva la capacità di diffondersi come un worm attraverso le reti LAN, poteva registrare e catturare screenshot e audio, poteva ascoltare e registrare le conversazioni Skype e poteva trasformare le stazioni di lavoro Bluetooth in apparati di ascolto che potevano poi esfiltrare e spostare i file in altri apparati, inviando infine i file a un server C2. Questo particolare malware ha preso di mira principalmente le organizzazioni del Medio Oriente.

L'INIZIO DELL’ERA MODERNA DEL RANSOMWARE

2011/12: Reveton

Reveton non è stato il primo "ransomware" dell'era di internet; nonostante questo, esso potrebbe essere definito come l'archetipo del moderno ransomware: le sue caratteristiche contribuirono a definire l’aspetto tipico dei ransomware, che li caratterizza ancora oggi, compresa l'onnipresente schermata di blocco che fornisce dettagli su ciò che è successo, come mettersi in contatto con i cybercriminali, come pagare il riscatto, come decifrare i file, ecc.

Reveton ricevette molta attenzione anche da parte della stampa in quanto presentava tutte le caratteristiche di un malware gestito da un'organizzazione di criminali informatici professionisti. Non era solo professionale nell'aspetto, ma utilizzava anche dei template: un’assoluta novità. Le schermate di blocco venivano mostrate agli utenti in base alla geolocalizzazione e consistevano in messaggio proveniente dalle forze dell'ordine locali, che veniva fornito insieme alle istruzioni su come effettuare il pagamento. Reveton ha utilizzato così tanti modelli che i ricercatori hanno spesso citato le release basate sui suoi template autunno/inverno/primavera/estate.

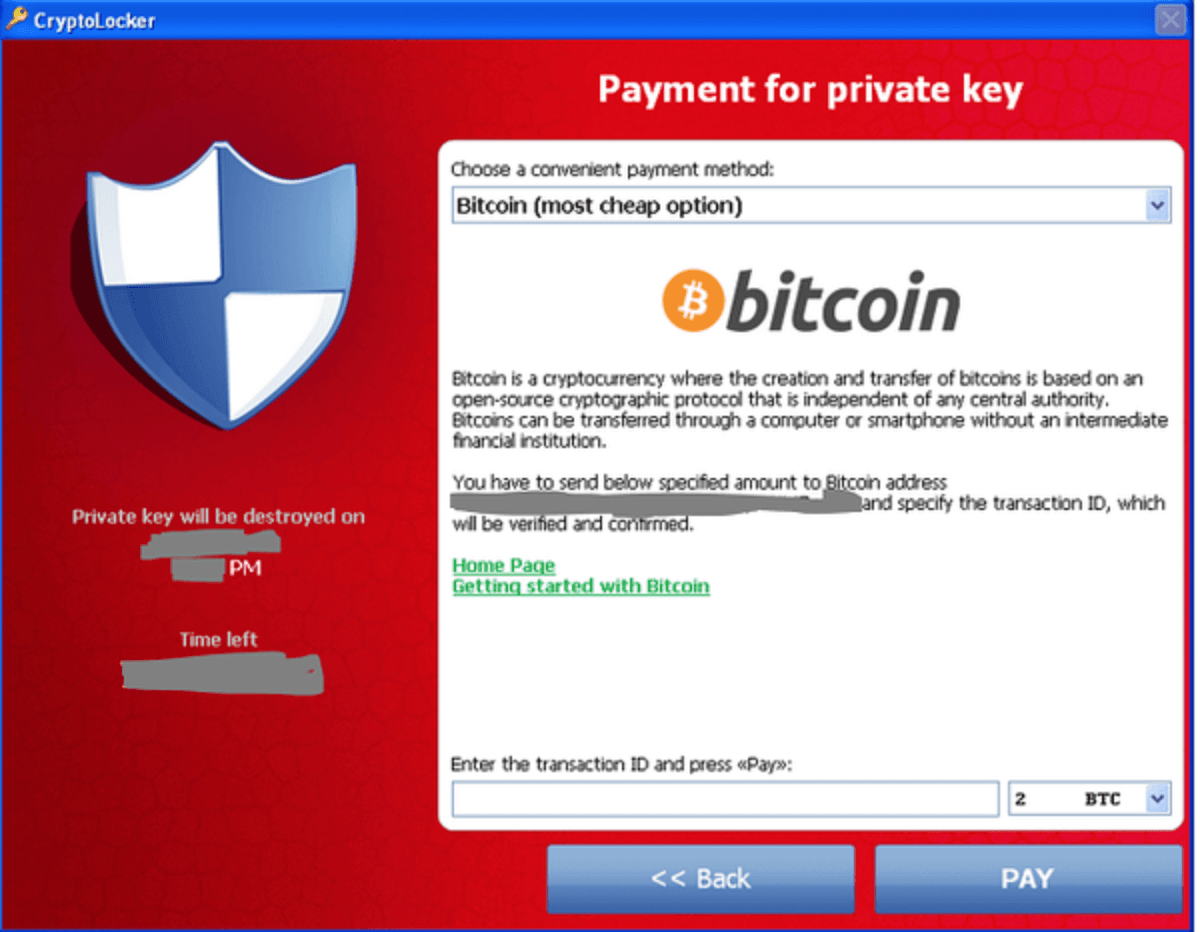

2013: CryptoLocker – la criptovaluta diventa un’opzione di pagamento

CryptoLocker è stato il primo ransomware a richiedere il pagamento del riscatto tramite Bitcoin. Il prezzo per la decrittazione era di due BTC, che nel 2013 (a seconda del momento) si attestava i 13 e i 1.100 dollari, il che ha fruttato ai creatori di questa particolare minaccia informatica una somma tutto sommato modesta. È importante ricordare come CryptoLocker sia nato in un momento in cui la criptovaluta era ancora nella sua fase iniziale, e convincere le vittime che non avevano particolari competenze tecniche non solo a pagare il riscatto richiesto ma anche a capire come usare la criptovaluta era un ostacolo non indifferente da superare.

2013: DarkSeoul e Lazarus

Oltre al ransomware, il 2013 ha visto anche la genesi degli attacchi sponsorizzati dagli Stati. Uno di questi, noto con il nome di DarkSeoul, prese di mira il 20 marzo 2013 l'emittente coreana SBS e gli istituti bancari in Corea del Sud. Il malware utilizzato, Jokra, aveva come target il master boot record (MBR) dei dispositivi, che sovrascriveva. Ad essere colpiti furono anche gli utenti dei provider di servizi internet, delle telecomunicazioni e dei bancomat, in quanto i loro network vennero messi offline. Questo attacco è stato attribuito a Lazarus (Corea del Nord), che prese di mira anche la Sony Corporation nel 2014 facendo trapelare informazioni riservate in risposta a "The Interview", un film che derideva il leader nordcoreano Kim Jong-un. In aggiunta, il team Lazarus è stato anche associato agli attacchi contro la Banca del Bangladesh del 2016. In questo caso venne messo in atto il tentativo di rubare 951 milioni di dollari, ma i cybercriminali riuscirono a farla franca solo con 81 milioni di dollari a causa di varie flag nella catena delle transazioni bancarie.

2015: Browser Locker e il Blue Screen Of Death (BSOD)

Le prime truffe del supporto tecnico, oltre a diverse varianti di browser locker, sono comparse nel 2015. Questa tipologia di attacchi agisce imitando il ransomware e inducendo così le proprie vittime a chiamare un numero al quale risponde un criminale informatico da un paese diverso fingendo di occuparsi del supporto tecnico o più semplicemente a pagare criptovalute per ripristinare il loro sistema. Con questo schema, il JavaScript dannoso è stato distribuito su siti web legittimi che sono stati così compromessi; in sostanza con questa modalità il browser veniva reso inutilizzabile, facendo comparire sul computer delle vittime avvisi e richieste in modalità a schermo intero. Un’altra variazione sul tema era quella che prevedeva la visualizzazione del cosiddetto “Blue Screen of Death” (BSOD), che sembrava convincente in tutto e per tutto, e che includeva un numero verde che veniva fatto passare per quello del supporto tecnico di Microsoft. In realtà, a rispondere era un criminale informatico che lavorava in un call center in un paese straniero. Con questa modalità, il cybercriminale avrebbe tentato di convincere la vittima a fornire l'accesso remoto al proprio dispositivo per rimediare al danno subito, per poi prendere il controllo della macchina con lo scopo di eseguire ulteriori azioni dannose, richiedendo tariffe esorbitanti per servizi inesistenti.

2016: compare la prima botnet IoT

Mirai è stata la prima botnet a prendere di mira i dispositivi IoT. Il suo target d’elezione erano i router di rete, ma ha incluso anche altri dispositivi IoT. Si trattava principalmente di una botnet DDoS, coinvolta in una serie di attacchi contro il sito web di Brian Krebs, krebsonsecurity.com, oltre ad essere responsabile di aver reso inaccessibile un enorme segmento di Internet, interrompendo l'accesso e i servizi in tutto il mondo.

A differenza della rete e dei dispositivi end-user, la maggior parte dei dispositivi IoT non riceve aggiornamenti su base automatica, come invece succede ai computer e agli smartphone. Ne risulta che essi siano spesso trascurati e aggiornati raramente, perché questa operazione richiederebbe che vengano “flashati” (cioè messi offline in modo che il software e il firmware possano essere sovrascritti interamente), il che può essere scomodo o risultare addirittura disastroso, perché i dispositivi flashati possono essere brickati (cioè resi permanentemente inutilizzabili) se il procedimento non viene eseguito nel modo corretto. A peggiorare le cose, molti utenti che collegano i propri dispositivi IoT a Internet non cambiano il nome utente e la password di default. Mirai ha sfruttato questa vulnerabilità, che gli ha permesso propagarsi senza alcuna difficoltà, diventando così prolifico da indurre anche il famoso crittologo Bruce Schneier a pensare che potesse essere la creazione di uno stato-nazione.

Mirai è stato un attacco di alto profilo non solo perché era nuovo nel suo genere, ma anche perché fu in grado di mettere insieme un esercito di botnet a livello globale in poco tempo, permettendo di reindirizzare il traffico internet da sistemi infetti in tutto il mondo verso siti mirati. Questo ha reso particolarmente difficile difendersi da Mirai, in quanto il flusso di traffico proveniva da più fronti. Le varianti di Mirai sono ancora vive e vegete e questo è in parte dovuto al fatto che gli sviluppatori hanno rilasciato il suo codice, disponibile per l’utilizzo di altri cybercriminali.

2017: ShadowBrokers (NSA), WannaCry, Petya/NotPetya

Il leak di ShadowBrokers ai danni della National Security Agency (NSA) degli Stati Uniti è stato senza precedenti nel suo genere e assolutamente devastante, non solo perché ha esposto l’esistenza di un malware sviluppato ai più alti livelli del governo degli Stati Uniti, ma anche perché gli attori delle minacce hanno convertito efficacemente gli strumenti e gli exploit. Questi strumenti, nome in codice "Fuzzbunch", erano sostanzialmente un exploitation framework sviluppato dalla NSA, che includeva un malware noto come DoublePulsar, un attacco backdoor che conteneva a sua volta il famigerato exploit "EternalBlue". Quest’ultimo era un exploit zero-day che la NSA conservava nel suo arsenale, che prendeva di mira il protocollo SMB (Server Message Block) di Microsoft (CVE-2017-0444).

È stato successivamente utilizzato per diffondere i famigerati ransomware WannaCry e Petya/NotPetya, che hanno avuto conseguenze disastrose, causando lo shutdown di impianti di produzione in tutto il mondo. Ad oggi, nessuno è stato in grado di attribuire l'hacking/leak di ShadowBrokers ad un'entità specifica.

2017: il mining di criptovalute

Anche se le minacce legate alle criptovalute sono state inizialmente limitate a ransomware o furti di wallet di criptovalute, il 2018 ha visto l’affacciarsi di una metodologia mai vista prima, ovvero XMRig. Si tratta in sostanza di un’applicazione miner, non dannosa, scritta per estrarre la criptovaluta Monero. Essa funziona utilizzando i cicli di CPU inutilizzati su una macchina per aiutare a risolvere vari problemi matematici utilizzati nel mining di criptovalute. Tuttavia, i cybercriminali hanno iniziato a installare surrettiziamente XMRig su macchine e dispositivi compromessi, per poi a raccogliere e aggregare i dati risultanti per il proprio profitto in criptovaluta.

Le vulnerabilità più comuni sfruttate dai vari attori malevoli hanno utilizzato exploit noti in Apache Struts, Oracle Weblogic e Jenkins Servers. Come risultato, questi attacchi sono stati relegati alle organizzazioni che utilizzavano queste specifiche tecnologie e, cosa più importante per i cybercriminali, le potenti CPU dei dispositivi su cui giravano. Queste vulnerabilità sono state prese di mira anche perché erano sfruttabili da remoto. A complicare le cose, a molte di queste macchine connesse a Internet non erano applicate le patch, permettendo così ai cybercriminali di sfruttarle.

Varianti di campagne che hanno incorporato XMRig nei loro attacchi hanno preso di mira i dispositivi mobili tramite APK Android dannosi, container docker, e attacchi alla supply chain che prendono di mira NPM (node package manager), per elencarne alcuni.

2019: GandCrab e il Ransomware as a Service

GandCrab ha aumentato il volume e la virulenza degli attacchi fornendo ransomware a pagamento a un ampio panel di potenziali utilizzatori. GandCrab aveva sostanzialmente due obiettivi: prendere le distanze dagli attacchi alle organizzazioni e generare più entrate. Ha così perfezionato il modello di business noto come “Ransomware-as-a-Service” (RaaS), che ha dato ai suoi autori il vantaggio di lavorare sul loro codice mentre altri eseguivano poi le violazioni effettive. In questo modello, gli affiliati facevano tutto il “lavoro sporco” (ricognizione, movimento laterale, delivery del ransomware, raccolta del denaro, ecc.) mentre gli autori rimanevano sullo sfondo e prendevano una parte (si stima che abbiano raccolto tra il 25% e il 40%) del riscatto effettivo.

Questa metodologia si è rivelata redditizia per entrambe le parti, poiché gli autori non hanno dovuto correre il rischio di identificare e infettare i propri obiettivi, e gli affiliati non hanno dovuto a loro volta spendere del tempo per cercare di sviluppare il ransomware da soli. GandCrab sembra anche aver seguito il processo di sviluppo Agile, con versioni minori e maggiori distribuite quando gli autori lo ritenevano opportuno. GandCrab ha poi annunciato il proprio ritiro nel giugno del 2019, dopo aver dichiarato di aver incassato 2 miliardi di dollari. Tuttavia, i suoi autori sono stati in seguito labilmente affiliati agli attori di minacce Sodonikibi e REvil, in particolare come parte del famigerato attacco dell'estate 2021 a Colonial Pipeline. Altre notevoli varianti RaaS che sono emerse dopo GandCrab sono BlackCat, Conti, DarkSide e Lockbit, per citarne alcune.

Termina qui il nostro viaggio nel Malaware

Tra il 1971 e i primi anni 2000, gli autori dei virus utilizzavano il malware per lo più per verificarne il funzionamento. Andando avanti di oltre 20 anni nella timeline, è facile notare come il panorama delle minacce informatiche si sia evoluto, includendo attività con scopo estorsivo e gli attacchi degli stati nazione. I "virus" si sono evoluti in "malware" onnicomprensivi, e questo riflette il cambiamento che ah avuto luogo. Non è inoltre una coincidenza che lo sviluppo e i cambiamenti di tali attacchi siano avvenuti in concomitanza con lo sviluppo del mondo iperconnesso in cui oggi viviamo.

Al termine di questo viaggio nel malware, una cosa rimane chiara: il più grande rischio sarà sempre l'elemento umano. Per prevenire i problemi legati ai possibili attacchi, può essere utile informarsi sulle minacce facendo affidamento a strumenti riconosciuti per la loro validità.

© 𝗯𝘆 𝗔𝗻𝘁𝗼𝗻𝗲𝗹𝗹𝗼 𝗖𝗮𝗺𝗶𝗹𝗼𝘁𝘁𝗼

Tutti i diritti riservati | All rights reserved

Informazioni Legali

I testi, le informazioni e gli altri dati pubblicati in questo sito nonché i link ad altri siti presenti sul web hanno esclusivamente scopo informativo e non assumono alcun carattere di ufficialità.

Non si assume alcuna responsabilità per eventuali errori od omissioni di qualsiasi tipo e per qualunque tipo di danno diretto, indiretto o accidentale derivante dalla lettura o dall'impiego delle informazioni pubblicate, o di qualsiasi forma di contenuto presente nel sito o per l'accesso o l'uso del materiale contenuto in altri siti.